A Milano fino al 24 febbraio, l’esposizione mostrerà ai visitatori il lato oscuro dell’uso pervasivo di tecnologie come il riconoscimento facciale

IA. Quello di Intelligenza Artificiale è un acronimo sconosciuto ai più fino a pochi anni fa, ma è già parte delle nostre vite. E il fatto che non ce ne accorgiamo è sinonimo di quanto il suo sviluppo sia in grado di supportare le attività umane in un modo che si potrebbe quasi definire naturale. C’è però un rovescio della medaglia, evidenziato da importanti questioni etiche. Dal riconoscimento facciale agli assistenti virtuali come Siri (Apple) e Cortana (Microsoft) fino ai dispositivi in grado di mappare le emozioni, sono migliaia le applicazioni rese possibili da una sempre maggiore potenza di calcolo delle macchine. Un fattore, questo, che pone importanti interrogativi che dovranno essere necessariamente affrontati nel prossimo futuro.

Come è iniziato tutto ciò? In che modo i primi calcolatori nati a metà del secolo scorso si sono evoluti fino a poter individuare e classificare informazioni biometriche precise di un individuo (spesso a sua insaputa)?

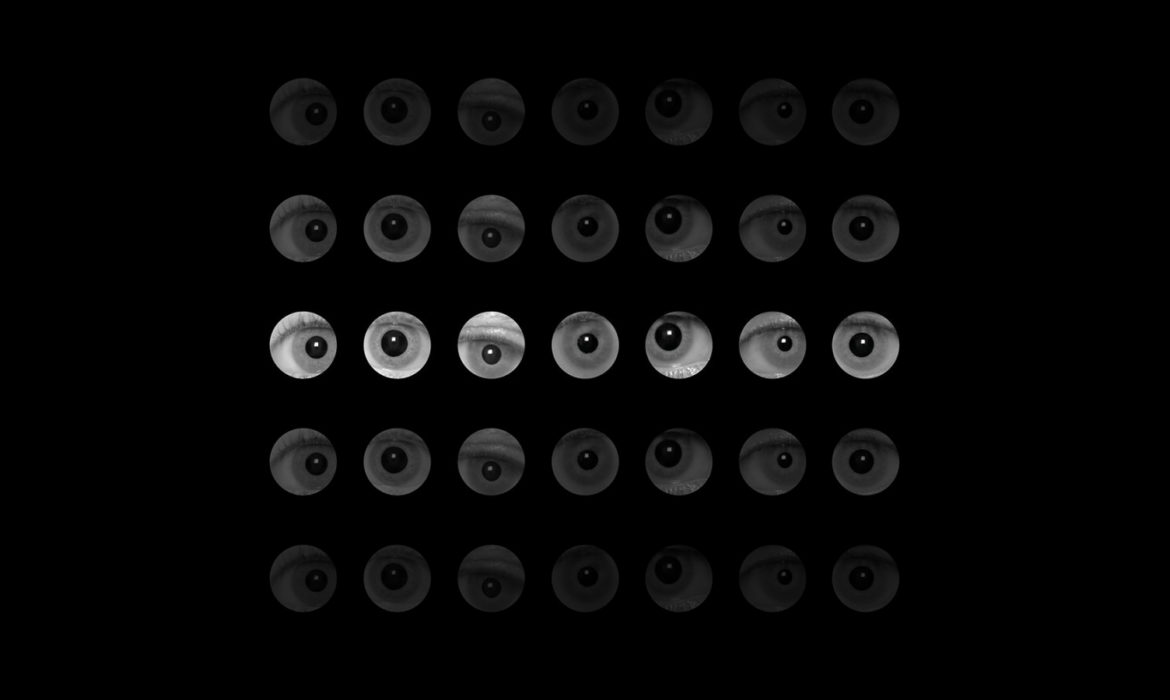

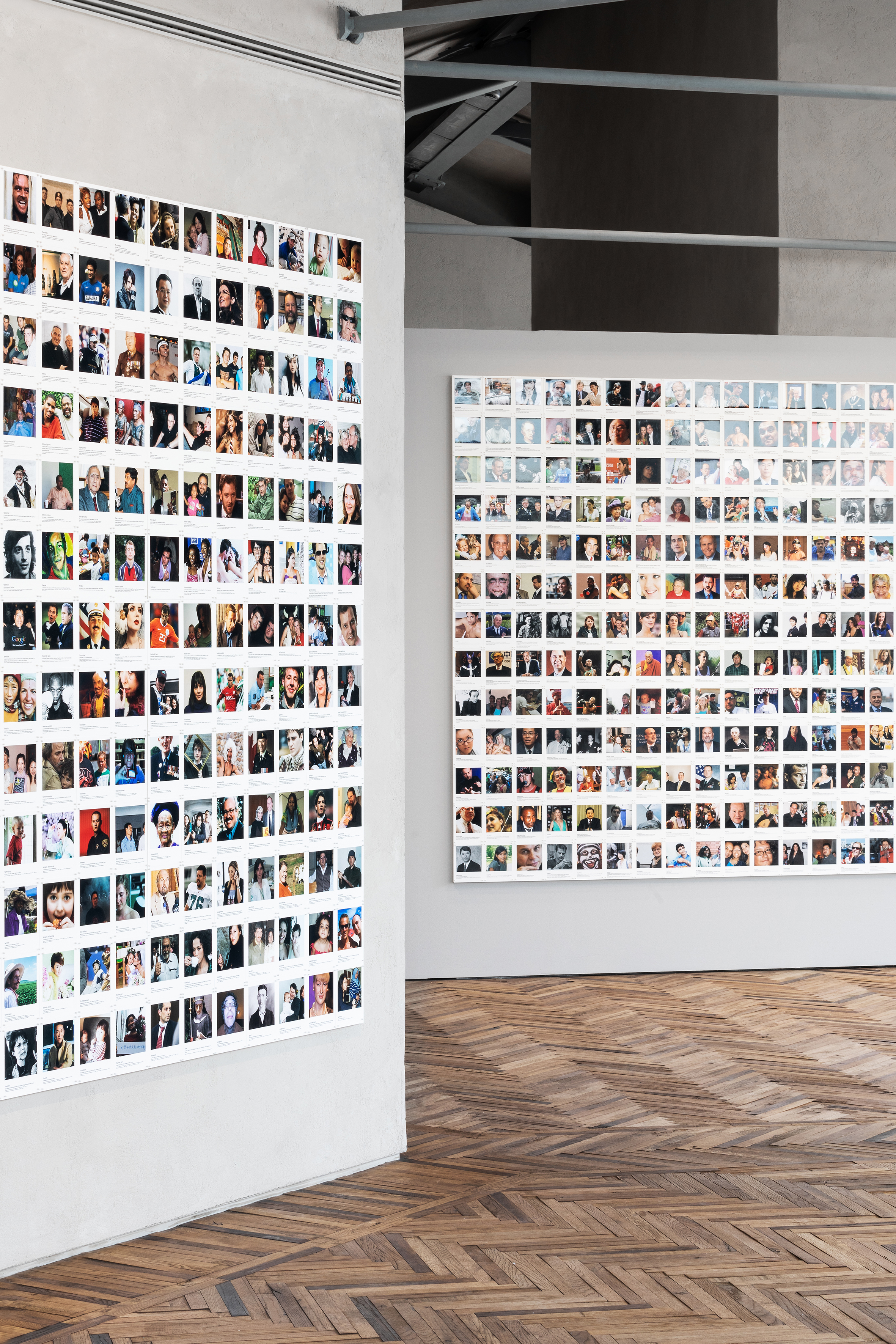

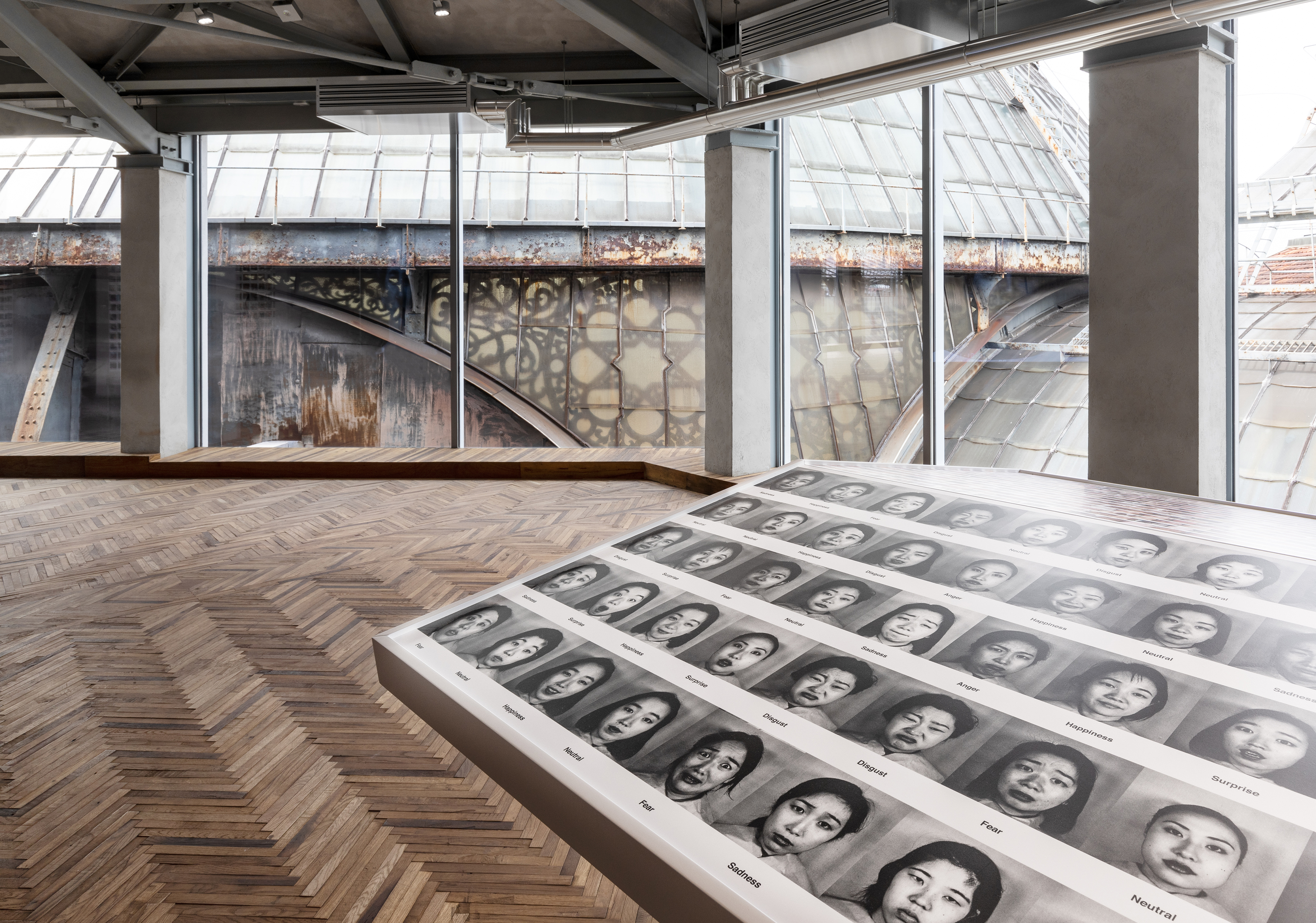

Da queste due domande prende il via la mostra organizzata presso la Fondazione Prada di Milano (12 settembre – 24 febbraio) da Kate Crawford, studiosa nell’ambito dell’intelligenza artificiale, e Trevor Paglen, artista e ricercatore. “Training Humans”, questo il nome dell’esposizione, punta proprio ad affrontare i preconcetti, le posizioni ideologiche e gli errori “made by humans” alla base di queste tecnologie sempre più pervasive e alle quali verranno affidati compiti con una curva di crescita esponenziale anche a livello di implicazioni. Per far questo, i due hanno concepito un percorso espositivo ricco di fotografie di repertorio utilizzate dagli scienziati con il compito di insegnare ai sistemi d’IA come vedere e classificare tutto ciò che ci circonda.

Kate Crawford e Trevor Paglen

«Training Humans – spiega Paglen – mostra come queste immagini facciano parte di una lunga tradizione che consiste nel raccogliere istantanee delle persone senza il loro consenso. Questo al fine di classificarle, segmentarle e, spesso, ricondurle a stereotipi attraverso modalità che evocano un passato coloniale». Un concetto ripreso dalla Crawford che sottolinea come «l’asimmetria di potere sia propria di questi strumenti. La nostra speranza è che la mostra segni il punto di partenza per iniziare a ripensare questi sistemi e per comprendere in modo scientifico come ci vedono e classificano».

Due le tematiche principali che il progetto vuole esplorare. Da un lato la rappresentazione e la codificazione di donne e uomini all’interno di sterminati database. Dall’altro le modalità con cui i software raccolgono, etichettano e utilizzano il materiale raccolto. Il tutto con l’obiettivo di mettere in luce come nella computer vision e nei sistemi di IA, i criteri si trasformino in modo nascosto in strumenti di giudizio morale. Per questo motivo i visitatori saranno messi di fronte a due interrogativi le cui risposte influenzeranno il modo in cui vivremo nel prossimo futuro. Quali sono i confini fra scienza, storia, politica, pregiudizio e ideologia nell’Intelligenza Artificiale? E chi ha il potere di costruire questi sistemi e trarne benefici?

© RIPRODUZIONE RISERVATA